Od kilku lat trwa rewolucja AI. Z każdego miejsca, każdej reklamy – ba! – z lodówki krzyczy do nas „AI” albo „sztuczna inteligencja”. Producenci oprogramowania prześcigają się w oferowaniu przełomowych, „inteligentnych” funkcji, dosłownie wszędzie jest już to coś.

Jak my żyliśmy do tej pory? Jakim cudem byliśmy cokolwiek w stanie robić, automatyzować, przyśpieszać? Szczególnie bliski jest mi temat tworzenia oprogramowania, dlatego postaram się w kilku akapitach to wyjaśnić.

„AI” czy „sztuczna inteligencja” to pojęcie jednocześnie nienowe i bardzo pojemne. Od „wybuchu” ChatGPT 3 i różnych produktów konkurencyjnych terminy te stały się modne. Wszyscy chcą mieć w swojej komunikacji marketingowej jakiś punkt zaczepienia. Tylko ChatGPT i inne to LLM – Large Language Model – duży model językowy, a to nie jest jedyny rodzaj AI.

Reguły biznesowe i automatyzacje procesów

Już tutaj zaczyna się „inteligencja” – reguła definiująca automatyzację np. „jeżeli A to B”. Tego typu reguła to tak banalna sprawa jak automatyzacja odpowiedzi na maila czy umieszczenie go w odpowiednim katalogu. Już na tym poziomie w oprogramowaniu zaszyty może zostać algorytm, który przejmuje zadanie inteligentnego użytkownika. Algorytmy postępowania w zależności od danych to bardzo pokaźny element rynku AI. Wchodzimy tutaj np. w automatyczne przetwarzanie formularzy czy inne powtarzalne zadania administracyjne.

Algorytmy podobieństwa i statystyka

Jak aplikacja ma rozpoznać, że „Kujawski” i „Kujwaski” są podobne? W takich przypadkach stosuje się algorytmy obliczające miary podobieństwa, takie jak algorytm Levenshteina, opisany już w 1965 roku. Działa on poprzez obliczenie minimalnej liczby operacji (wstawień, usunięć i zamian znaków), które przekształcą jeden ciąg znaków w drugi. Dzięki temu można automatycznie identyfikować słowa z literówkami lub drobnymi błędami.

Z kolei algorytmy statystyczne umożliwiają prognozowanie przyszłych trendów na podstawie danych historycznych. Metody tego typ wykorzystywane są na przykład w analizach giełdowych, gdzie pozwalają przewidywać zmiany na rynkach finansowych.

I zaczyna się zaawansowana nauka

Idąc dalej wkraczamy w dużo bardziej zaawansowane obszary jak uczenie maszynowe (Machine Learning – ML). W skrócie – definiujemy algorytm postępowania i pozwalamy programowi ćwiczyć jego stosowanie na dużym pakiecie danych. Tutaj pojawiają się już sieci neuronowe. Deep Learning (DLM) to zaawansowana forma uczenia maszynowego, a wykorzystywana np. do analizy obrazów i głosu.

„Im dalej w las, tym więcej drzew” – mówimy, chcąc opisać rosnącą złożoność problemów. W kontekście AI można by powiedzieć: „Im bardziej inteligentna sztuczna inteligencja, tym więcej (i większych) sieci neuronowych”.

Od uczenia maszynowego do dużych modeli językowych (LLM) takich jak ChatGPT jeszcze daleka droga, ale nie wdawajmy się teraz w szczegóły techniczne. Jak na zewnątrz działa ChatGPT i jego konkurencja pewnie wszyscy zdążyliście się już dowiedzieć.

Z armatą na muchę

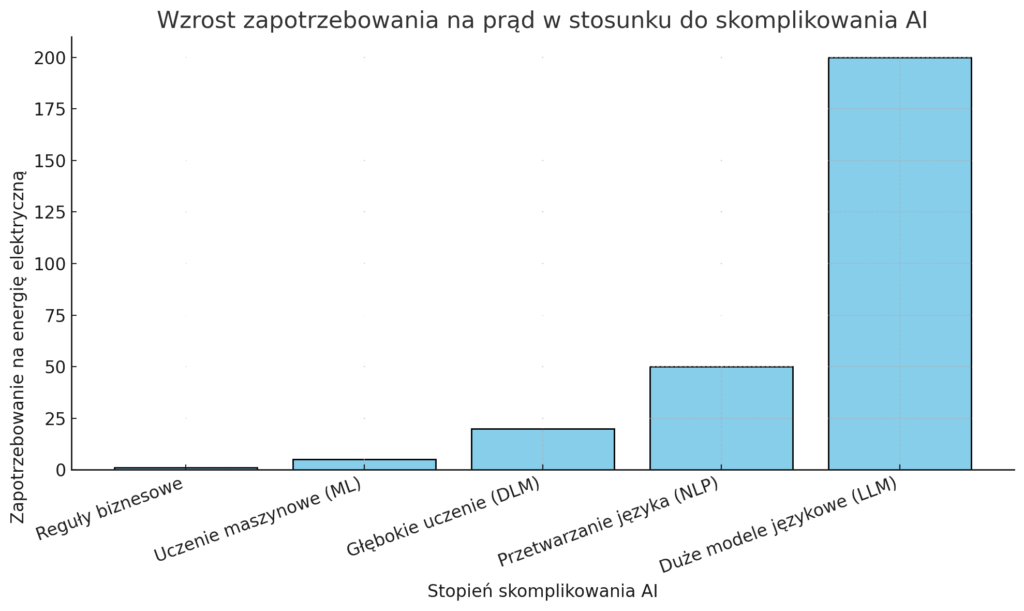

Wszystkie poruszone powyżej wątki łączy jedno – można je zakwalifikować jako rodzaje sztucznej inteligencji. Jak widać, w świecie technicznym nie zawsze konieczne jest stosowanie dużych modeli językowych (LLM). W wielu przypadkach można osiągnąć zamierzony efekt za pomocą prostszych, szybszych i bardziej energooszczędnych rozwiązań.

W kontekście zmian klimatycznych i zrównoważonego rozwoju warto zwrócić uwagę na poniższy wykres. Pokazuje on korelację między stopniem zaawansowania sztucznej inteligencji a rosnącym zapotrzebowaniem na energię elektryczną. Wyciągnięcie wniosków pozostawiam już Wam.